Le LiDAR est l’une de ces brillantes exclusivités des appareils Apple qui permettent à iOS de se distinguer d’Android. Du moins, c’est le cas si vous savez ce qu’est le LiDAR. Cette technologie est particulièrement importante pour les activités de réalité augmentée sur mobile, mais, comme pour la plupart des fonctions technologiques exclusives à Apple, Android a sa propre solution. Dans ce cas, il s’agit de la technologie ToF, disponible sur les téléphones phares de Samsung.

Que vous soyez développeur, à la recherche d’un nouvel appareil ou simplement curieux, il vaut la peine de prendre le temps de décortiquer ces acronymes et d’apprendre les tenants et les aboutissants de la détection de la profondeur sur les téléphones portables.

Qu’est-ce que la ToF ?

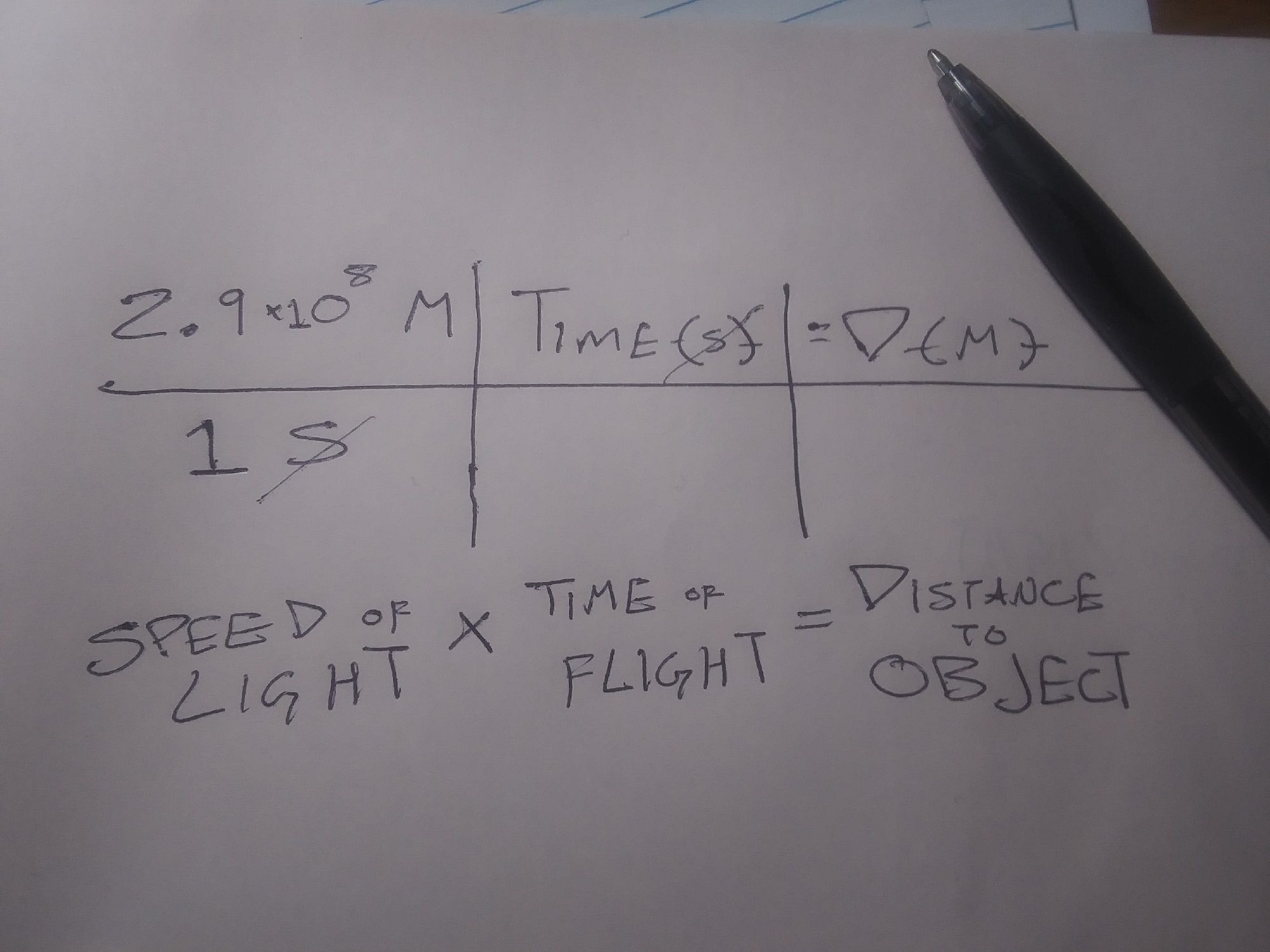

ToF est l’abréviation de « Time of Flight » (temps de vol). Techniquement, le ToF fait référence à l’utilisation de la vitesse de la lumière (ou même du son) pour déterminer la distance.

Un capteur ToF spécial mesure le temps nécessaire à la lumière (ou au son) pour quitter l’appareil, rebondir sur un objet ou un avion et revenir à l’appareil. Ce nombre divisé par deux indique la distance entre l’appareil et l’objet ou le plan.

La relation est donc la suivante : tous les LiDAR sont un type de temps de vol, mais tous les temps de vol ne sont pas des LiDAR. Pour simplifier les choses, lorsque nous parlons de « ToF », nous parlons de la mesure de la distance optique, à l’exclusion du LiDAR.

Donc, si le LiDAR et le ToF optique non-LiDAR utilisent tous deux la lumière pour déterminer la distance et la cartographie 3D, en quoi sont-ils différents ?

Qu’est-ce que le LiDAR ?

LiDAR est l’abréviation de Light Detection and Ranging (détection et télémétrie par la lumière). Le LiDAR utilise un laser, ou une grille de lasers, comme source lumineuse dans l’équation décrite ci-dessus.

Un seul relevé LiDAR peut être utilisé pour mesurer des éléments tels que la largeur d’une pièce, mais plusieurs relevés LiDAR peuvent être utilisés pour créer des « nuages de points ». Ceux-ci peuvent être utilisés pour créer des modèles tridimensionnels d’objets ou des cartes topographiques de zones entières.

Si le LiDAR est une nouveauté pour les appareils mobiles, cette technologie existe depuis les années 1960. Dans des contextes non mobiles, le LiDAR est utilisé pour tout, de la cartographie des environnements sous-marins à la découverte de sites archéologiques depuis l’espace.

En quoi le LiDAR et la ToF sont-ils différents ?

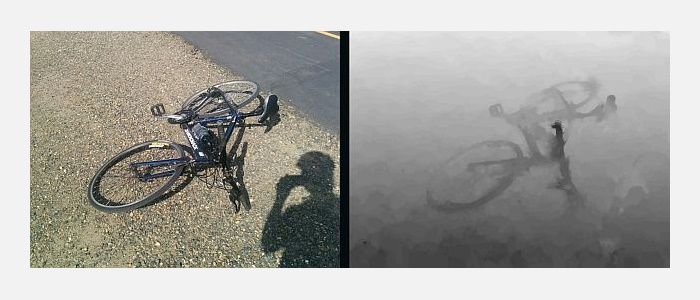

La différence fonctionnelle entre le LiDAR et les autres formes de ToF est que le LiDAR utilise des lasers pulsés pour construire un nuage de points, qui est ensuite utilisé pour construire une carte ou une image en 3D, tandis que les applications de ToF créent des « cartes de profondeur » basées sur la détection de la lumière, généralement par le biais d’une caméra RVB standard.

L’avantage de la ToF par rapport au LiDAR est que la ToF nécessite un équipement moins spécialisé et peut donc être utilisée avec des appareils plus petits et moins coûteux. L’avantage du LiDAR réside dans la facilité avec laquelle un ordinateur peut lire un nuage de points par rapport à une carte de profondeur.

L’API de profondeur créée par Google pour les appareils Android fonctionne mieux sur les appareils dotés de la technologie ToF et permet de créer des cartes de profondeur et de reconnaître les « points caractéristiques ». Ces points caractéristiques, souvent des barrières entre différentes intensités lumineuses, sont ensuite utilisés pour identifier différents plans dans l’environnement. Cela permet de créer un nuage de points à faible résolution.

Comment la ToF et le LiDAR fonctionnent-ils avec la RA mobile ?

Les cartes de profondeur et les nuages de points sont cool et, pour certaines personnes et applications, ils sont suffisants. Par exemple, les cartes de profondeur permettent aux appareils photo des téléphones de faire la mise au point correctement, et le LiDAR est la technologie qui permet aux iPhones de scanner votre visage pour un verrouillage d’écran plus personnel (bien que les nouveaux modèles Android puissent également le faire).

Cependant, pour la plupart des applications de RA, ces données doivent être contextualisées. La ToF et le LiDAR y parviennent en travaillant avec d’autres capteurs de l’appareil mobile. Plus précisément, ces plateformes doivent comprendre l’orientation et le mouvement de votre téléphone.

La localisation de l’appareil dans un environnement cartographié est appelée localisation et cartographie simultanées (SLaM). La SLaM est nécessaire pour que les applications mobiles de RA puissent placer des objets numériques dans l’environnement physique.

Cela est particulièrement vrai pour les expériences qui restent en place lorsque l’utilisateur n’interagit pas avec elles et pour le placement d’objets numériques qui semblent se trouver derrière des personnes et des objets physiques.

Un autre facteur important dans le placement d’objets numériques dans les applications LiDAR et ToF concerne les « ancres ». Les ancres sont des points numériques dans le monde physique auxquels les objets numériques sont « attachés ».

Dans les applications à l’échelle mondiale comme Pokemon Go, cela se fait par le biais d’un processus distinct appelé « géolocalisation ». Toutefois, dans les applications mobiles de RA, l’objet numérique est ancré à des points dans un nuage de points LiDAR ou à l’un des points d’une carte de profondeur.

Le LiDAR est-il meilleur que la ToF ?

À proprement parler, le LiDAR est plus rapide et plus précis que le temps de vol. Cependant, cela devient plus significatif avec des applications technologiquement plus avancées.

Par exemple, ToF et l’API de profondeur de Google ont des difficultés à comprendre les plans de grande taille et de faible texture comme les murs blancs. Il peut donc être difficile pour les applications utilisant cette méthode de placer avec précision des objets numériques sur certaines surfaces du monde physique. Les applications utilisant le LiDAR sont moins susceptibles de rencontrer ce problème.

Toutefois, les applications impliquant des environnements plus vastes ou plus variés sur le plan textural ne sont pas susceptibles de rencontrer ce problème. En outre, la plupart des applications mobiles de RA destinées au grand public impliquent l’utilisation d’un filtre de RA sur le visage ou le corps de l’utilisateur, une application qui a peu de chances de rencontrer des problèmes en raison des grandes surfaces non texturées.

Pourquoi Apple et Google utilisent-ils des capteurs de profondeur différents ?

Lors de la sortie de ses appareils compatibles LiDAR, Apple a déclaré avoir inclus les capteurs ainsi que d’autres matériels dans le but « d’ouvrir davantage de flux de travail professionnels et de prendre en charge les applications photo et vidéo professionnelles ». Le communiqué qualifie également l’iPad Pro compatible LiDAR de « meilleur appareil au monde pour la réalité augmentée » et vante les mérites des applications de mesure d’Apple.

Google n’a pas donné d’explications aussi directes sur les raisons pour lesquelles son API de profondeur et les appareils compatibles n’utilisent pas le LiDAR. Outre le fait de contourner le LiDAR et de rendre les appareils Android plus légers et plus abordables, il existe également un avantage majeur en termes d’accessibilité.

Android fonctionnant sur des appareils mobiles fabriqués par plusieurs sociétés, l’utilisation de LiDAR favoriserait les modèles compatibles avec LiDAR au détriment de tous les autres. En outre, l’API de profondeur est rétrocompatible avec un plus grand nombre d’appareils car elle ne nécessite qu’une caméra standard.

En fait, l’API de profondeur de Google est agnostique, ce qui signifie que les développeurs qui utilisent la plateforme de création d’expériences de réalité augmentée de Google peuvent également développer des expériences qui fonctionnent sur les appareils Apple.

Avez-vous exploré la détection de profondeur ?

Cet article s’est principalement concentré sur le LiDAR et la ToF dans les expériences de RA basées sur le mobile. Cela s’explique en grande partie par le fait que ces expériences plus complexes sont celles qui nécessitent le plus d’explications. C’est aussi parce que ces expériences sont les plus amusantes et les plus prometteuses.

Cependant, les approches de détection de profondeur comme celles-ci sont à la base de nombreuses expériences et outils plus simples et plus pratiques que vous pouvez utiliser tous les jours sans y penser. Nous espérons que la lecture de ToF et LiDAR vous permettra de mieux apprécier ces applications.