L’intelligence artificielle (IA) va transformer des pans entiers de notre société, que nous le voulions ou non, et cela inclut le World Wide Web.

Avec des logiciels comme ChatGPT accessibles à toute personne disposant d’une connexion internet, il devient de plus en plus difficile de distinguer les contenus générés par l’IA de ceux créés par un être humain. Heureusement que nous avons des détecteurs de contenu généré par l’IA, n’est-ce pas ?

Les détecteurs de contenu IA fonctionnent-ils ?

Les détecteurs de contenu IA sont des outils spécialisés qui permettent de déterminer si un texte a été écrit par un programme informatique ou par un être humain. Si vous tapez les mots « AI content detector » sur Google, vous verrez qu’il existe des dizaines de détecteurs, qui prétendent tous pouvoir faire la différence entre un texte humain et un texte non humain.

Leur fonctionnement est assez simple : vous collez un texte et l’outil vous indique s’il a été généré par l’IA ou non. En termes plus techniques, en utilisant une combinaison de techniques de traitement du langage naturel et d’algorithmes d’apprentissage automatique, les détecteurs de contenu d’IA recherchent des modèles et de la prévisibilité, et font des appels sur cette base.

Cela semble très bien sur le papier, mais si vous avez déjà utilisé un outil de détection de l’IA, vous savez très bien qu’ils sont aléatoires, et c’est un euphémisme. Le plus souvent, ils détectent des contenus rédigés par des humains comme étant de l’IA, ou des textes créés par des êtres humains comme étant générés par l’IA. En fait, certains d’entre eux sont terriblement mauvais dans ce qu’ils sont censés faire.

Quelle est la précision des détecteurs de contenu de l’IA ?

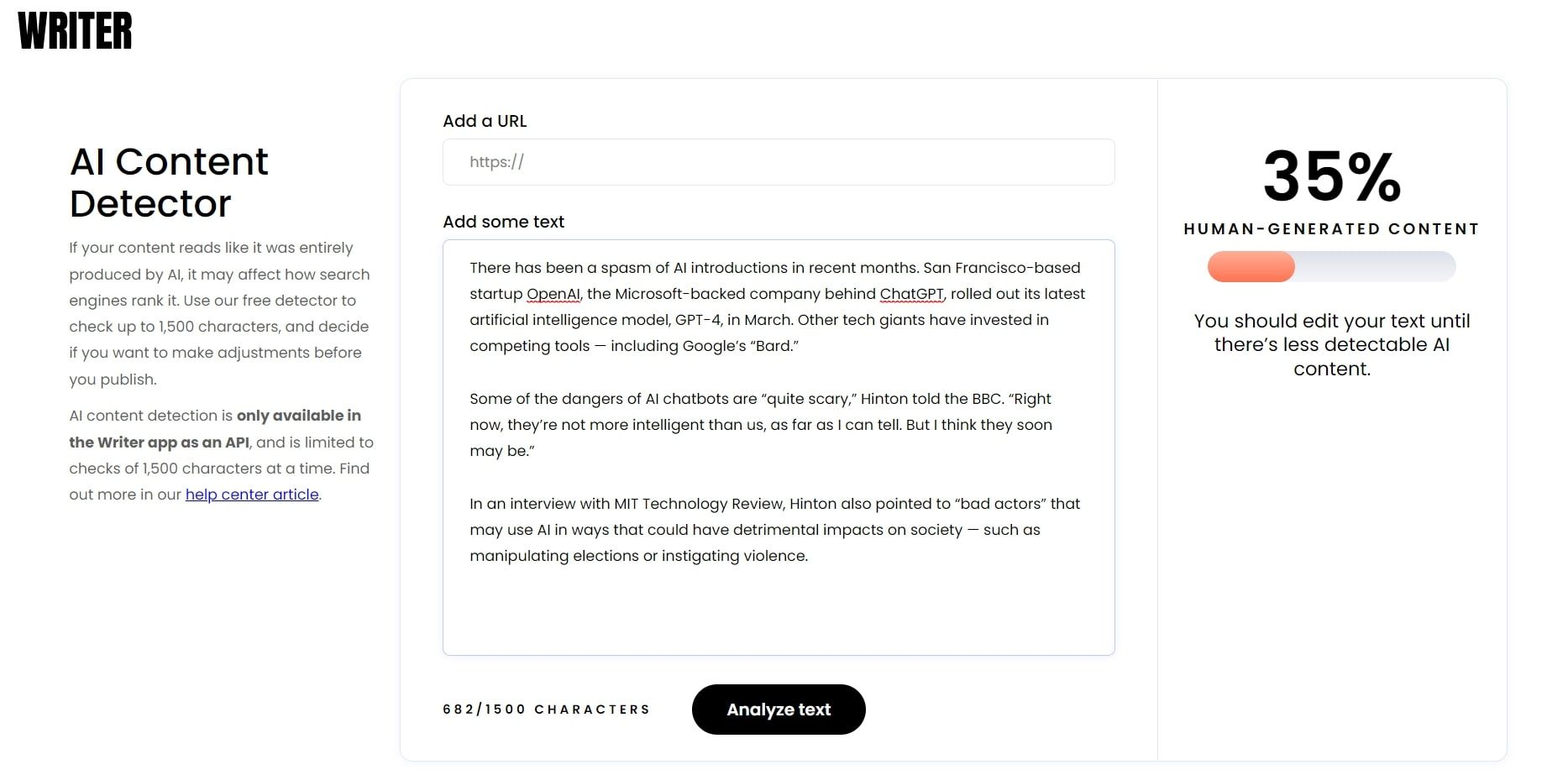

Si vous êtes aux États-Unis, le premier résultat de recherche Google pour « AI content detector » est writer.com (anciennement connu sous le nom de Qordoba ; il s’agit d’une plateforme de contenu d’intelligence artificielle qui possède également son propre détecteur). Mais lorsque vous collez une section de cet article aléatoire de l’Associated Press dans l’outil, celui-ci affirme qu’il y a de fortes chances qu’il ait été généré par une intelligence artificielle.

Writer.com s’est donc trompé.

Pour être honnête, les autres détecteurs de contenu d’IA ne sont guère plus performants. Non seulement ils produisent des faux positifs, mais ils marquent également le contenu de l’IA comme étant humain. Et même lorsque ce n’est pas le cas, il suffit d’apporter des modifications mineures au texte généré par l’IA pour qu’il passe haut la main.

En février 2023, Armin Alimardani, maître de conférences à l’université de Wollongong, et Emma A. Jane, professeur associé à l’UNSW de Sydney, ont testé un certain nombre de détecteurs de contenu d’IA populaires et ont établi qu’aucun d’entre eux n’était fiable. Dans leur analyse, publiée dans The Conversation, Alimardani et Jane ont conclu que cette « course aux armements » entre les générateurs de texte et les détecteurs d’IA constituera un défi important à l’avenir, en particulier pour les éducateurs.

Mais les éducateurs et les enseignants ne sont pas les seuls à avoir des raisons de s’inquiéter : c’est le cas de tout le monde. À mesure que les textes générés par l’IA deviennent omniprésents, il sera de plus en plus difficile de faire la différence entre ce qui est « réel » et ce qui ne l’est pas, c’est-à-dire de repérer si quelque chose a été écrit par l’IA. Cette évolution aura un impact considérable sur pratiquement toutes les industries et tous les domaines de la société, y compris les relations personnelles.

Implications de l’IA pour la cybersécurité et la protection de la vie privée

Le fait qu’il n’existe aucun mécanisme fiable permettant de déterminer si un objet a été créé par un logiciel ou par un être humain a de graves conséquences pour la cybersécurité et la protection de la vie privée.

Les acteurs de la menace utilisent déjà le ChatGPT pour écrire des logiciels malveillants, générer des courriels d’hameçonnage, écrire des spams, créer des sites frauduleux, etc. Bien qu’il existe des moyens de se défendre contre cela, il est inquiétant de constater qu’il n’existe pas de logiciel capable de différencier de manière fiable le contenu organique du contenu d’un robot.

Les fausses nouvelles constituent également un problème majeur. Grâce à l’IA générative, les agents de désinformation sont en mesure d’étendre leurs opérations comme jamais auparavant. Une personne ordinaire, quant à elle, n’a aucun moyen de savoir si ce qu’elle lit en ligne a été créé par un logiciel ou par un être humain.

La protection de la vie privée est une toute autre affaire. Prenons l’exemple de ChatGPT. Il a été alimenté par plus de 300 milliards de mots avant son lancement. Ce contenu a été puisé dans des livres, des blogs, des forums, des articles et des médias sociaux. Il a été recueilli sans le consentement de quiconque et avec un mépris apparemment total pour la protection de la vie privée et des droits d’auteur.

Il y a aussi la question des faux positifs. Si un contenu est signalé par erreur comme étant généré par l’IA, cela ne risque-t-il pas de conduire à la censure, qui est de toute façon un problème majeur ? Sans parler des dommages que le fait d’être accusé d’utiliser un texte créé par l’IA pourrait causer à la réputation d’une personne, à la fois en ligne et dans la vie réelle.

S’il existe effectivement une course aux armements entre l’IA générative et les détecteurs de contenu, l’IA générative est en train de gagner. Pire encore, il ne semble pas y avoir de solution. Tout ce que nous avons, ce sont des produits à moitié construits qui ne fonctionnent même pas la moitié du temps, ou qui peuvent être trompés très facilement.

Comment détecter le contenu de l’IA : Solutions potentielles

Le fait que nous ne semblions pas avoir de véritables réponses à ce problème ne signifie pas que nous n’en aurons pas à l’avenir. En fait, il existe déjà plusieurs propositions sérieuses qui pourraient fonctionner. Le filigrane en est une.

En ce qui concerne l’IA et les modèles de langage profond, le filigrane consiste à intégrer une sorte de code secret dans un texte généré par l’IA (par exemple, un modèle de mot, un style de ponctuation). Un tel filigrane serait invisible à l’œil nu et donc pratiquement impossible à supprimer, mais des logiciels spécialisés seraient capables de le détecter.

En fait, en 2022, des chercheurs de l’université du Maryland ont mis au point une nouvelle méthode de filigrane pour les réseaux neuronaux artificiels. Le chercheur principal, Tom Goldstein, a déclaré à l’époque que son équipe avait réussi à « prouver mathématiquement » que leur filigrane ne pouvait pas être entièrement supprimé.

Pour l’instant, une personne ordinaire peut se fier à son instinct et à son bon sens. Si le contenu que vous lisez n’est pas naturel, répétitif, sans imagination ou banal, il est possible qu’il ait été créé par un logiciel. Bien entendu, vous devez également vérifier toutes les informations que vous voyez en ligne, revérifier la source et vous tenir à l’écart des sites web douteux.

La révolution de l’IA est en marche

Certains affirment que la cinquième révolution industrielle est déjà en marche, l’intelligence artificielle occupant le devant de la scène dans ce qui est décrit comme une convergence du numérique et du physique. Que ce soit réellement le cas ou non, tout ce que nous pouvons faire, c’est nous adapter.

La bonne nouvelle, c’est que le secteur de la cybersécurité s’adapte à cette nouvelle réalité et met en œuvre de nouvelles stratégies de défense avec l’IA et l’apprentissage automatique au premier plan.