OpenAI a enfin lancé sa très attendue mise à jour GPT, GPT-4. Le Grand Modèle de Langage (LLM) est livré avec de nouvelles fonctionnalités et capacités puissantes qui ont déjà choqué les utilisateurs du monde entier.

En plus d’être nettement meilleur que le GPT-3.5, le LLM existant qui alimente le chatbot viral ChatGPT d’OpenAI, le GPT-4 peut comprendre des entrées plus complexes, a une limite d’entrée de caractères beaucoup plus grande, a des capacités multimodales, et est apparemment plus sûr à utiliser.

1. GPT-4 peut comprendre des données plus complexes

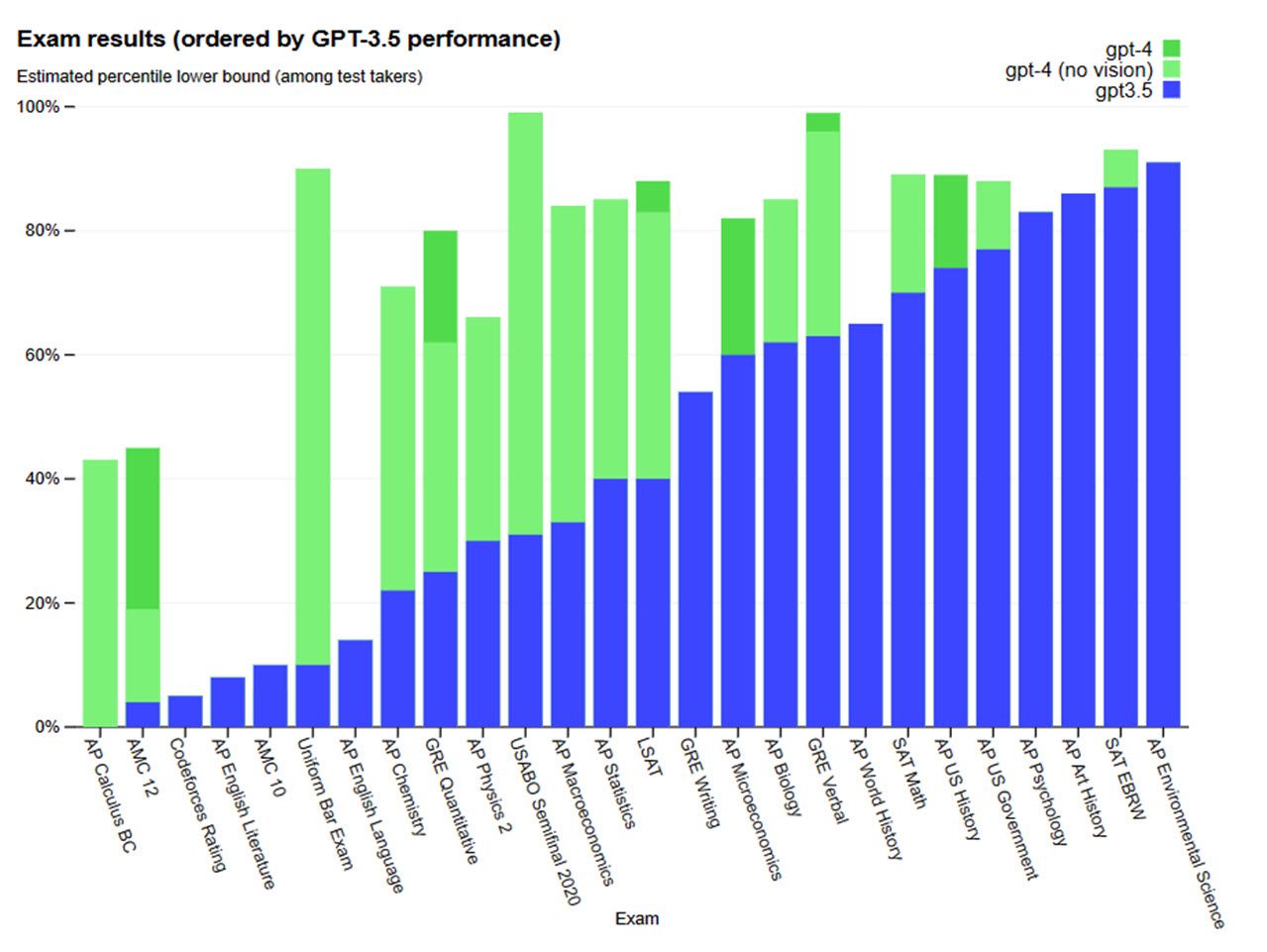

L’une des principales nouveautés de GPT-4 est sa capacité à comprendre des messages plus complexes et plus nuancés. Selon OpenAI, GPT-4 « affiche des performances de niveau humain sur divers critères professionnels et académiques ».

La démonstration a été faite en soumettant GPT-4 à plusieurs examens de niveau humain et à des tests standardisés, tels que le SAT, le BAR et le GRE, sans formation spécifique. Non seulement GTP-4 a compris et résolu ces tests avec un score relativement élevé, mais il a également battu son prédécesseur, GPT-3.5, à chaque fois.

La capacité à comprendre des messages plus nuancés est également facilitée par le fait que GPT-4 a une limite de mots beaucoup plus importante. Le nouveau modèle peut traiter des invites de saisie allant jusqu’à 25 000 mots (pour mémoire, GPT-3.5 était limité à 8 000 mots). Cela aura une incidence directe sur le niveau de détail que les utilisateurs peuvent introduire dans leurs invites, ce qui permettra au modèle de travailler avec beaucoup plus d’informations et de produire des résultats plus longs.

GPT-4 prend également en charge plus de 26 langues, y compris des langues à faibles ressources telles que le letton, le gallois et le swahili. Lors de l’évaluation comparative de la précision à trois coups sur le benchmark MMLU, GPT-4 a battu GPT-3.5 ainsi que d’autres LLM de premier plan tels que PaLM et Chinchilla en termes de performance en langue anglaise dans 24 langues.

2. Capacités multimodales

La version précédente de ChatGPT se limitait à des invites textuelles. En revanche, l’une des caractéristiques les plus récentes de GPT-4 est sa capacité multimodale. Le modèle peut accepter à la fois des invites textuelles et des images.

Cela signifie que l’IA peut accepter une image en entrée et l’interpréter et la comprendre comme une invite textuelle. Cette capacité s’applique à toutes les tailles et à tous les types d’images et de textes, y compris les documents combinant les deux, les croquis dessinés à la main et même les captures d’écran.

Cependant, les capacités de lecture d’images de GPT-4 vont au-delà de leur simple interprétation. OpenAI l’a montré dans son flux de développeurs (ci-dessus), en fournissant à GPT-4 une maquette dessinée à la main d’un site web de blagues. Le modèle a été chargé d’écrire du code HTML et JavaScript pour transformer la maquette en site web tout en remplaçant les blagues par des blagues réelles.

GPT-4 a écrit le code en utilisant la mise en page spécifiée dans la maquette. Lors des tests, le code a produit un site fonctionnel avec, comme vous pouvez le deviner, de vraies blagues. Cela signifie-t-il que les progrès de l’IA signifieront la fin de la programmation ? Pas tout à fait, mais c’est une fonction qui sera utile pour aider les programmeurs.

Aussi prometteuse que soit cette fonctionnalité, elle est encore en phase de recherche et n’est pas accessible au public. En outre, le modèle prend beaucoup de temps pour traiter les entrées visuelles, OpenAI ayant elle-même déclaré qu’il faudrait du temps et du travail pour qu’il devienne plus rapide.

3. Une meilleure dirigeabilité

OpenAI affirme également que la GPT-4 présente un degré élevé de manœuvrabilité. Il est également plus difficile pour l’IA de changer de caractère, ce qui signifie qu’elle est moins susceptible d’échouer lorsqu’elle est mise en œuvre dans une application pour jouer un certain personnage.

Les développeurs peuvent prescrire le style et la tâche de leur IA en décrivant la direction dans le message « système ». Ces messages permettent aux utilisateurs de l’API de personnaliser fortement l’expérience utilisateur dans certaines limites. Étant donné que ces messages constituent également le moyen le plus facile de « jailbreaker » le modèle, les développeurs s’efforcent également de les rendre plus sûrs. La démo de GPT-4 a mis ce point en évidence en demandant à un utilisateur d’essayer d’empêcher GPT-4 d’être un tuteur socratique et de répondre à sa question. Cependant, le modèle a refusé de rompre le caractère.

4. Sécurité

OpenAI a passé six mois à rendre GPT-4 plus sûr et plus aligné. L’entreprise affirme qu’il est 82 % moins susceptible de répondre à des demandes de contenu inapproprié ou autrement interdit, 29 % plus susceptible de répondre conformément aux politiques d’OpenAI à des demandes sensibles, et 40 % plus susceptible de produire des réponses factuelles par rapport à GPT-3.5.

Il n’est pas parfait, et vous pouvez toujours vous attendre à ce qu’il « hallucine » de temps en temps et à ce qu’il se trompe dans ses prédictions. Certes, GPT-4 a de meilleures perceptions et un meilleur pouvoir de prédiction, mais il ne faut pas pour autant faire aveuglément confiance à l’IA.

5. Amélioration des performances

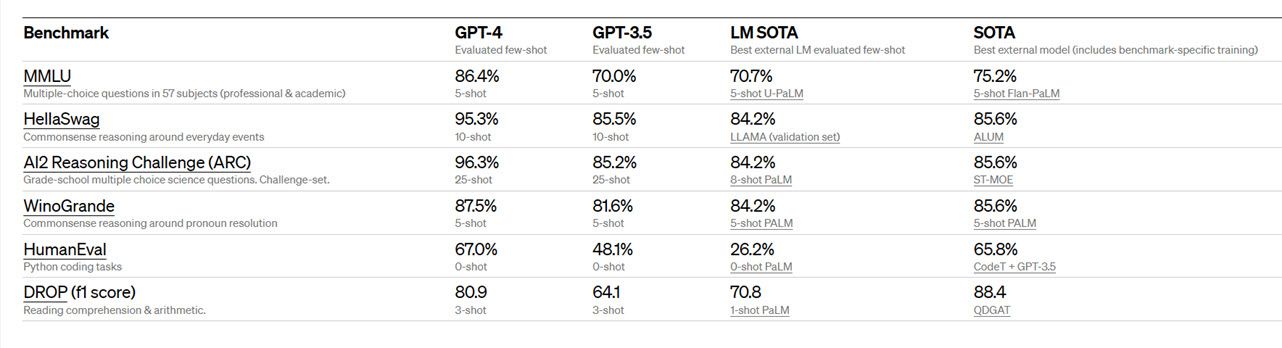

Outre l’évaluation des performances du modèle sur des examens humains, OpenAI a également évalué le robot sur des critères de référence traditionnels conçus pour les modèles d’apprentissage automatique.

Elle affirme que GPT-4 « surpasse considérablement » les LLM existants et « la plupart des modèles de pointe ». Ces tests comprennent le MMLU susmentionné, l’AI2 Reasoning Challenge (ARC), WinoGrande, HumanEval et Drop, qui testent tous les capacités individuelles.

Vous obtiendrez des résultats similaires en comparant les performances des tests de vision académique. Les tests effectués comprennent VQAv2, TextVQA, ChartQA, AI2 Diagram (AI2D), DocVQA, Infographic VQA, TVQA et LSMDC, pour lesquels la GPT-4 obtient les meilleurs résultats. Cependant, l’OpenAI a déclaré que les résultats de GPT-4 dans ces tests « ne représentent pas complètement l’étendue de ses capacités », car les chercheurs continuent de trouver de nouveaux défis plus difficiles à relever pour le modèle.

Un petit pas pour GPT-4, un grand pas pour l’IA

Avec plus de précision, de sécurité d’utilisation et de capacités avancées, GPT-4 a été mis à la disposition du public via le plan d’abonnement mensuel ChatGPT+ qui coûte 20 euros par mois. En outre, l’OpenAI s’est associée à différentes organisations pour commencer à construire des produits grand public avec GPT-4. Microsoft Bing, Duolingo, Stripe, Be My Eyes et Khan Academy, entre autres, ont déjà intégré la GPT-4 dans leurs produits.

GPT-4 est peut-être une mise à jour incrémentale par rapport à GPT-3.5, mais c’est une grande victoire pour l’IA en général. À mesure que le modèle devient plus accessible, à la fois pour l’utilisateur moyen et pour les développeurs grâce à son API, il semble qu’il constituera un bon argument en faveur de l’implémentation de LLM dans tous les domaines.