Les signes révélateurs d’une image truquée étaient autrefois faciles à repérer, mais l’IA générative nous fait remettre en question pratiquement tout ce que nous voyons et entendons aujourd’hui. Avec chaque nouveau modèle d’IA, les signes révélateurs d’une image truquée diminuent et, pour ajouter à la confusion, vous pouvez désormais créer de fausses vidéos, des clones vocaux de vos proches et fabriquer de faux articles en quelques secondes seulement.

Pour éviter d’être trompé par les deepfakes de l’IA, il est utile de connaître les dangers qu’ils représentent.

L’évolution des deepfakes

Un deepfake montre une personne faisant quelque chose qui ne s’est jamais produit dans la vie réelle. C’est complètement faux. Nous nous moquons des deepfakes lorsqu’ils sont partagés sur l’internet sous forme de mème ou de blague, mais très peu de gens trouvent cela drôle lorsqu’ils sont utilisés pour nous induire en erreur.

Dans le passé, les deepfakes étaient créés en prenant une photo existante et en la modifiant dans un logiciel de retouche d’image comme Photoshop. Mais ce qui distingue les deepfakes de l’IA, c’est qu’ils peuvent être générés à partir de zéro à l’aide d’algorithmes d’apprentissage en profondeur.

Le dictionnaire Merriam-Webster définit un deepfake comme suit :

Une image ou un enregistrement qui a été modifié et manipulé de manière convaincante pour présenter quelqu’un comme faisant ou disant quelque chose qui n’a pas été réellement fait ou dit.

Mais avec les progrès de la technologie de l’IA, cette définition commence à sembler dépassée. Grâce à l’utilisation d’outils d’IA, les deepfakes comprennent désormais des images, du texte, des vidéos et le clonage de la voix. Parfois, les quatre modes de génération d’IA sont utilisés simultanément.

Parce qu’il s’agit d’un processus automatisé incroyablement rapide et bon marché, c’est l’outil idéal pour produire des deepfakes à un rythme jamais vu auparavant, sans qu’il soit nécessaire d’avoir la moindre connaissance en matière d’édition de photos, de vidéos ou d’audio.

Les grands dangers de l’IA Deepfakes

Il existe déjà une multitude de générateurs de vidéos d’IA, ainsi que de nombreux générateurs de voix d’IA. Ajoutez à cela un grand modèle linguistique comme le GPT-4 et vous obtenez la recette pour créer les deepfakes les plus crédibles que nous ayons vus jusqu’à présent dans l’histoire moderne.

Connaître les différents types d’IA deepfakes et la manière dont elles peuvent être utilisées pour vous tromper est un moyen d’éviter d’être induit en erreur. Voici quelques exemples sérieux de la façon dont la technologie des deepfakes d’IA représente une menace réelle.

1. Le vol d’identité par l’IA

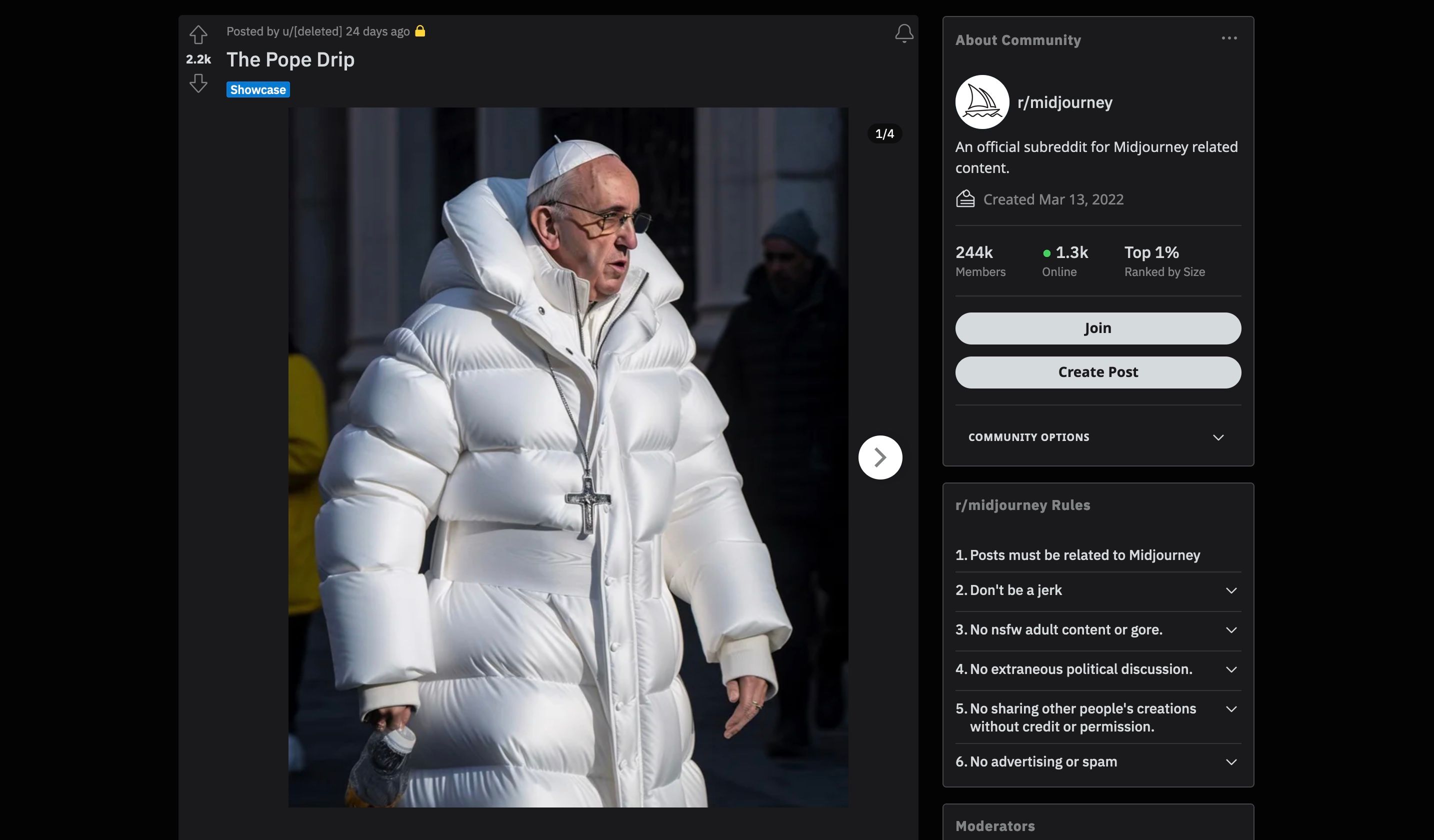

Vous les avez peut-être vus. Parmi les premiers deepfakes d’IA véritablement viraux qui se sont répandus dans le monde, on trouve une image de Donald Trump en train de se faire arrêter et une image du pape François vêtu d’une veste blanche.

Si l’une de ces images semble être une réimagination innocente de ce qu’une personnalité religieuse célèbre pourrait porter par une journée fraîche à Rome, l’autre, qui montre une personnalité politique dans une situation grave avec la loi, a des conséquences bien plus importantes si elle est prise pour la réalité.

Jusqu’à présent, les gens ont surtout ciblé des célébrités, des personnalités politiques et d’autres personnes célèbres lorsqu’ils ont créé des deepfakes d’IA. Cela s’explique en partie par le fait que les personnes célèbres ont de nombreuses photos d’elles sur l’internet, ce qui a probablement permis d’entraîner le modèle en premier lieu.

Dans le cas d’un générateur d’images d’IA comme Midjourney – utilisé dans le deepfake de Trump et du Pape – l’utilisateur doit simplement saisir un texte décrivant ce qu’il veut voir. Des mots-clés peuvent être utilisés pour spécifier le style artistique, comme une photographie ou un photoréalisme, et les résultats peuvent être affinés en augmentant la résolution.

Vous pouvez tout aussi bien apprendre à utiliser Midjourney et tester cela vous-même, mais pour des raisons morales et juridiques évidentes, vous devez éviter de diffuser ces images publiquement.

Malheureusement, le fait d’être un être humain moyen, non célèbre, ne garantit pas non plus que vous soyez à l’abri des deepfakes de l’IA.

Le problème réside dans une fonctionnalité clé offerte par les générateurs d’images d’IA : la possibilité de télécharger votre propre image et de la manipuler avec l’IA. Un outil comme Outpainting dans DALL-E 2 permet d’étendre une image existante au-delà de ses limites en saisissant une invite textuelle et en décrivant les autres éléments que vous souhaitez générer.

Si quelqu’un d’autre devait faire cela avec vos photos, les dangers pourraient être bien plus grands que le deepfake du Pape en veste blanche – il pourrait l’utiliser n’importe où, en se faisant passer pour vous. Si la plupart des gens utilisent l’IA avec de bonnes intentions, il existe très peu de restrictions empêchant les gens de l’utiliser pour nuire, en particulier dans les cas d’usurpation d’identité.

2. Escroqueries au clone vocal Deepfake

Avec l’aide de l’IA, les « deepfakes » ont franchi une limite à laquelle la plupart d’entre nous n’étaient pas préparés : les faux clones de voix. Avec seulement une petite quantité de données audio originales – provenant peut-être d’une vidéo TikTok que vous avez publiée ou d’une vidéo YouTube dans laquelle vous apparaissez – un modèle d’IA peut reproduire votre seule et unique voix.

Il est à la fois étrange et effrayant d’imaginer recevoir un appel téléphonique qui ressemble à celui d’un membre de sa famille, d’un ami ou d’un collègue. Les faux clones vocaux sont un problème suffisamment grave pour que la Commission fédérale du commerce (FTC) ait publié un avertissement à ce sujet.

Ne vous fiez pas à la voix. Appelez la personne qui est censée vous avoir contacté et vérifiez l’histoire. Utilisez un numéro de téléphone que vous savez être le sien. Si vous ne parvenez pas à joindre votre proche, essayez de le contacter par l’intermédiaire d’un autre membre de la famille ou de ses amis.

Le Washington Post a rapporté le cas d’un couple de septuagénaires qui a reçu un appel téléphonique d’une personne ressemblant comme deux gouttes d’eau à leur petit-fils. Il était en prison et avait un besoin urgent d’argent pour payer sa caution. N’ayant aucune raison de douter de l’identité de leur interlocuteur, ils ont remis l’argent à l’escroc.

Les personnes âgées ne sont pas les seules à courir des risques : le Guardian rapporte un autre exemple, celui d’un directeur de banque qui a approuvé une transaction de 35 millions de dollars après avoir reçu une série d’appels fictifs d’une personne qu’il croyait être un directeur de banque.

3. Fake News produites en masse

Les grands modèles de langage, comme ChatGPT, sont très, très doués pour produire des textes qui ressemblent à s’y méprendre à ceux d’un humain, et nous ne disposons pas actuellement d’outils efficaces pour repérer la différence. Entre de mauvaises mains, les fausses nouvelles et les théories du complot seront peu coûteuses à produire et plus longues à démystifier.

La diffusion de fausses informations n’a rien de nouveau, bien sûr, mais un article de recherche publié sur arXiv en janvier 2023 explique que le problème réside dans la facilité avec laquelle il est possible d’augmenter la production à l’aide d’outils d’intelligence artificielle. Il s’agit de « campagnes d’influence générées par l’IA », qui pourraient, selon eux, être utilisées par les politiciens pour externaliser leurs campagnes politiques.

La combinaison de plusieurs sources générées par l’IA crée un deepfake de haut niveau. Par exemple, un modèle d’IA peut générer un article de presse bien écrit et convaincant pour accompagner la fausse image de l’arrestation de Donald Trump. Cela lui donne plus de légitimité que si l’image était partagée seule.

Les fausses nouvelles ne se limitent pas non plus aux images et aux écrits. Les progrès de l’IA dans la génération de vidéos signifient que nous voyons de plus en plus de deepfake vidéos apparaître. Voici une vidéo de Robert Downey Jr. greffée sur une vidéo d’Elon Musk, postée par la chaîne YouTube Deepfakery.

Pour créer un deepfake, il suffit de télécharger une application. Vous pouvez utiliser une application comme TokkingHeads pour transformer des images fixes en avatars animés, ce qui vous permet de télécharger votre propre image et du son pour donner l’impression que la personne parle.

La plupart du temps, c’est divertissant et amusant, mais il y a aussi des risques d’ennuis. Cela nous montre à quel point il est facile d’utiliser l’image de n’importe qui pour faire croire que cette personne a prononcé des mots qu’elle n’a jamais prononcés.

Ne vous laissez pas abuser par une IA Deepfake

Les « deepfakes » peuvent être déployés rapidement, à très faible coût et avec un faible niveau d’expertise ou de puissance de calcul. Elles peuvent prendre la forme d’une image générée, d’un clone vocal ou d’une combinaison d’images, de sons et de textes générés par l’IA.

Il était autrefois beaucoup plus difficile et laborieux de produire un deepfake, mais aujourd’hui, avec les nombreuses applications d’IA disponibles, tout le monde a accès aux outils utilisés pour créer des deepfakes. La technologie de l’IA deepfake devenant de plus en plus avancée, il convient de surveiller de près les dangers qu’elle représente.