Google a dévoilé la nouvelle génération de son modèle de langage Pathways (PaLM 2) le 10 mai 2023, lors de la conférence Google I/O 2023. Son nouveau grand modèle de langage (LLM) présente de nombreuses améliorations par rapport à son prédécesseur (PaLM) et pourrait enfin être prêt à affronter son plus grand rival, le GPT-4 d’OpenAI.

Mais quelles sont les améliorations apportées par Google ? PaLM 2 fait-il la différence comme l’espère Google et, plus important encore, avec tant de capacités similaires, en quoi PaLM 2 est-il différent de GPT-4 d’OpenAI ?

PaLM 2 vs. GPT-4 : Aperçu des performances

Le PaLM 2 est doté de capacités nouvelles et améliorées par rapport à son prédécesseur. L’un des avantages uniques du PaLM 2 par rapport au GPT-4 est le fait qu’il est disponible dans des tailles plus petites, spécifiques à certaines applications qui ne disposent pas d’une puissance de traitement embarquée aussi importante.

Toutes ces tailles différentes ont leurs propres modèles plus petits appelés Gecko, Otter, Bison et Unicorn, Gecko étant le plus petit, suivi par Otter, Bison et enfin Unicorn, le plus grand modèle.

Google affirme également que les capacités de raisonnement de WinoGrande et de DROP ont été améliorées par rapport à celles de GPT-4, le premier obtenant une faible marge dans ARC-C. Cependant, il y a une amélioration significative dans tous les domaines lorsqu’il s’agit de PaLM et de SOTA.

PaLM 2 est également meilleur en mathématiques, selon le document de recherche de 91 pages de Google sur PaLM 2. [PDF]. Cependant, la façon dont Google et OpenAI ont structuré les résultats de leurs tests rend difficile la comparaison directe des deux modèles. Google a également omis certaines comparaisons, probablement parce que PaLM 2 n’était pas aussi performant que GPT-4.

En MMLU, GPT-4 a obtenu un score de 86,4, tandis que PaLM 2 a obtenu un score de 81,2. Il en va de même pour HellaSwag, où GPT-4 a obtenu 95,3, alors que PaLM 2 n’a pu obtenir que 86,8, et pour ARC-E, où GPT-4 et PaLM 2 ont obtenu respectivement 96,3 et 89,7.

Le plus grand modèle de la famille PaLM 2 est PaLM 2-L. Bien que nous ne connaissions pas sa taille exacte, nous savons qu’il est nettement plus petit que le plus grand modèle PaLM, mais qu’il utilise davantage de calculs d’entraînement. D’après Google, le modèle PaLM compte 540 milliards de paramètres, de sorte que l’expression « nettement plus petit » devrait situer PaLM 2 dans une fourchette comprise entre 10 et 300 milliards de paramètres. N’oubliez pas que ces chiffres ne sont que des hypothèses basées sur ce que Google a dit dans le document PaLM 2.

Si ce nombre est proche de 100 milliards ou inférieur, PaLM 2 est très probablement plus petit en termes de paramètres que GPT-3.5. Le fait qu’un modèle potentiellement inférieur à 100 milliards puisse rivaliser avec GPT-4 et même le battre dans certaines tâches est impressionnant. Au départ, GPT-3.5 a tout balayé sur son passage, y compris PaLM, mais PaLM 2 s’est bien repris.

Différences entre les données d’entraînement de GPT-4 et de PaLM 2

Bien que Google n’ait pas dévoilé la taille de l’ensemble de données d’entraînement de PaLM 2, l’entreprise indique dans son document de recherche que l’ensemble de données d’entraînement du nouveau LLM est nettement plus important. OpenAI a adopté la même approche lors de la présentation de GPT-4, ne faisant aucune déclaration sur la taille de l’ensemble de données d’entraînement.

Cependant, Google souhaitait se concentrer sur une compréhension plus approfondie des mathématiques, de la logique, du raisonnement et de la science, ce qui signifie qu’une grande partie des données d’entraînement de PaLM 2 est axée sur les sujets susmentionnés. Google indique dans son document que le corpus de préformation de PaLM 2 est composé de sources multiples, notamment de documents web, de livres, de codes, de données mathématiques et conversationnelles, ce qui lui confère des améliorations sur tous les plans, du moins par rapport à PaLM.

Les compétences conversationnelles de PaLM 2 devraient également être d’un autre niveau étant donné que le modèle a été entraîné dans plus de 100 langues afin de lui donner une meilleure compréhension du contexte et de meilleures capacités de traduction.

En ce qui concerne les données d’entraînement de GPT-4, OpenAI nous a indiqué qu’elle avait entraîné le modèle à l’aide de données accessibles au public et de données sous licence. La page de recherche de GPT-4 indique que « les données sont un corpus de données à l’échelle du web comprenant des solutions correctes et incorrectes à des problèmes mathématiques, des raisonnements faibles et forts, des déclarations auto-contradictoires et cohérentes, et représentant une grande variété d’idéologies et d’idées ».

Lorsqu’une question est posée à GPT-4, il peut produire une grande variété de réponses, qui ne sont pas toutes pertinentes pour votre requête. Pour l’aligner sur l’intention de l’utilisateur, OpenAI a affiné le comportement du modèle en utilisant l’apprentissage par renforcement et le retour d’information humain.

Bien que nous ne connaissions pas les données exactes sur lesquelles ces modèles ont été formés, nous savons que l’intention de formation était très différente. Nous devrons attendre et voir comment cette différence d’intention de formation différencie les deux modèles dans un déploiement réel.

Chatbots et services PaLM 2 et GPT-4

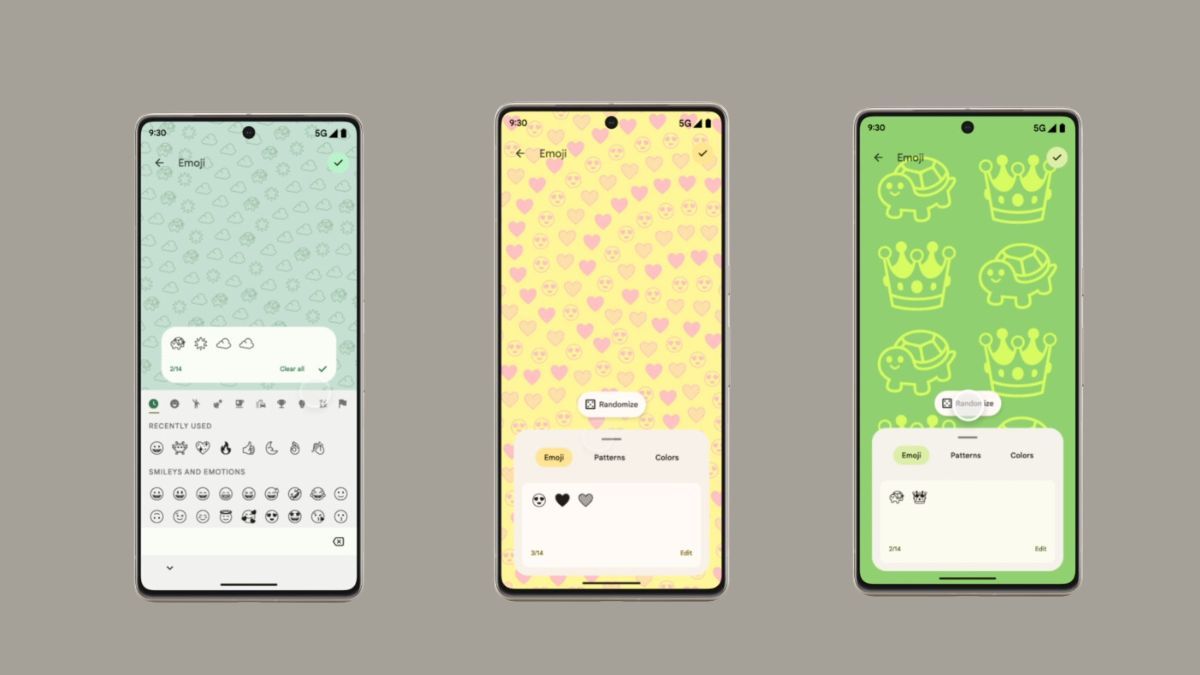

Le premier portail d’accès aux deux LLM est l’utilisation de leurs chatbots respectifs, Bard de PaLM 2 et ChatGPT de GPT-4. Cela dit, GPT-4 est derrière un paywall avec ChatGPT Plus, et les utilisateurs gratuits n’ont accès qu’à GPT-3.5. Bard, quant à lui, est gratuit pour tous et disponible dans 180 pays.

Cela ne veut pas dire que vous ne pouvez pas accéder à GPT-4 gratuitement non plus. Bing AI Chat de Microsoft utilise GPT-4 et est entièrement gratuit, ouvert à tous et disponible juste à côté de Bing Search, le plus grand rival de Google dans ce domaine.

Google I/O 2023 a été rempli d’annonces sur la façon dont PaLM 2 et l’intégration de l’IA générative amélioreront l’expérience Google Workspace avec des fonctionnalités d’IA à venir dans Google Docs, Sheets, Slides, Gmail, et à peu près tous les services offerts par le géant de la recherche. En outre, Google a confirmé que PaLM 2 avait déjà été intégré dans plus de 25 produits Google, dont Android et YouTube.

À titre de comparaison, Microsoft a déjà intégré des fonctions d’IA à la suite de programmes Microsoft Office et à un grand nombre de ses services. À l’heure actuelle, vous pouvez découvrir les deux LLM dans leurs propres versions d’offres similaires de deux entreprises rivales qui s’affrontent dans la bataille de l’IA.

Cependant, étant donné que GPT-4 est sorti tôt et qu’il a pris soin d’éviter bon nombre des erreurs commises par Google avec le Bard original, il a été le LLM de facto pour les développeurs tiers, les startups et à peu près tous ceux qui cherchent à incorporer un modèle d’IA capable dans leur service jusqu’à présent. Nous avons une liste d’applications GPT-4 si vous souhaitez les consulter.

Cela ne veut pas dire que les développeurs ne passeront pas à PaLM 2, ou du moins ne l’essaieront pas, mais Google doit encore rattraper OpenAI sur ce front. Et le fait que PaLM 2 soit open-source, au lieu d’être enfermé derrière une API payante, signifie qu’il a le potentiel d’être plus largement adopté que GPT-4.

PaLM 2 peut-il rivaliser avec GPT-4 ?

PaLM 2 est encore très récent, et la réponse à la question de savoir s’il peut ou non prendre en charge GPT-4 n’a pas encore été apportée. Cependant, avec tout ce que Google promet et la manière agressive dont il a décidé de le propager, il semble que PaLM 2 puisse donner du fil à retordre à GPT-4.

Cependant, GPT-4 reste un modèle très performant et, comme nous l’avons déjà mentionné, il surpasse PaLM 2 dans de nombreuses comparaisons. Cela dit, les nombreux modèles plus petits de PaLM 2 lui donnent un avantage irréfutable. Gecko lui-même est si léger qu’il peut fonctionner sur des appareils mobiles, même hors ligne. Cela signifie que PaLM 2 peut prendre en charge une classe entièrement différente de produits et d’appareils qui pourraient avoir du mal à utiliser GPT-4.

La course à l’IA s’intensifie

Avec le lancement de PaLM2, la course à la domination de l’IA s’est accélérée, car il pourrait bien s’agir du premier adversaire digne de ce nom à s’opposer à GPT-4. Avec un modèle d’IA multimodale plus récent appelé « Gemini » également en cours de formation, Google ne montre aucun signe de ralentissement.