Les grands modèles de langage ont le potentiel de révolutionner votre façon de vivre et de travailler, et peuvent tenir des conversations et répondre à des questions avec un degré de précision variable.

Pour en utiliser un, vous devez généralement disposer d’un compte auprès d’un fournisseur de LLM et vous connecter via un site web ou une application dédiée. Mais saviez-vous que vous pouviez exécuter votre propre modèle linguistique de grande taille entièrement hors ligne sur Linux ?

Pourquoi exécuter un grand modèle de langage sous Linux ?

Les grands modèles de langage (LLM) sont omniprésents aujourd’hui. Ils peuvent traiter le langage naturel et donner des réponses appropriées qui peuvent vous faire croire qu’un humain vous a répondu. Microsoft déploie une nouvelle version de Bing alimentée par l’IA, tandis que Bard d’Alphabet fait désormais partie intégrante des recherches sur Google.

Loin des moteurs de recherche, vous pouvez utiliser ce que l’on appelle des « chatbots d’IA » pour répondre à des questions, composer des poèmes ou même faire vos devoirs à votre place.

Mais en accédant aux LLM en ligne, vous dépendez de la bonne volonté d’un fournisseur tiers, qui peut vous être retirée à tout moment.

Vous êtes également soumis à des restrictions d’utilisation. Demandez à OpenAI d’écrire un roman érotique de 6 000 mots se déroulant dans l’Allemagne nazie, par exemple, et vous obtiendrez une réponse du type « Je vous prie de m’excuser, mais je ne pourrai pas générer cette histoire pour vous ».

Tout ce que vous entrez dans les LLM en ligne est utilisé pour les former davantage, et les données que vous souhaitez garder confidentielles peuvent être crachées à l’avenir dans le cadre d’une réponse à une question posée par quelqu’un d’autre.

Vous êtes également soumis à un manque de service, car le système est inondé d’utilisateurs, et on vous incite à vous abonner, afin que vous puissiez accéder à la plateforme lorsque la demande est forte.

Dalai est une implémentation libre et gratuite de LLaMa LLM de Meta et d’Alpaca de Stanford. Il fonctionne confortablement sur du matériel modeste et fournit une interface web pratique et une gamme de modèles d’invite, de sorte que vous pouvez demander ce que vous voulez, sans craindre qu’un administrateur ferme votre compte, que le LLM refuse de répondre, ou que votre connexion soit coupée.

Lorsque vous installez un LLM localement sous Linux, il vous appartient et vous pouvez l’utiliser comme bon vous semble.

Comment installer Dalai sur Linux

La façon la plus simple d’installer Dalai sur Linux est d’utiliser Docker et Docker Compose. Si vous ne les avez pas encore, consultez notre guide sur l’installation de Docker et Docker Compose.

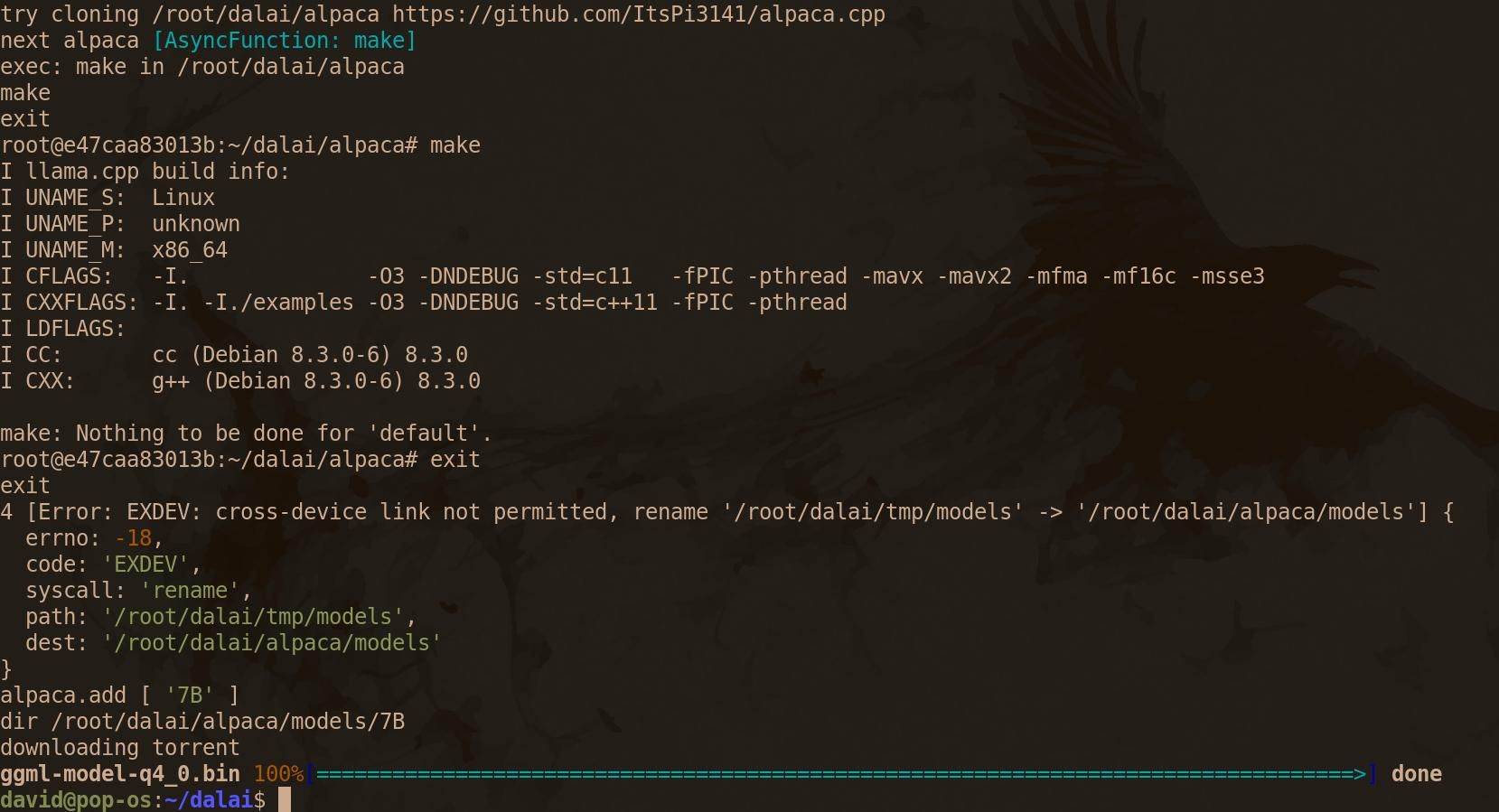

Ceci étant dit, vous êtes prêt à installer Dalai. Clonez le dépôt Dalai GitHub et utilisez la commande cd pour y accéder :

git clone https://github.com/cocktailpeanut/dalai.git && cd dalai Pour faire fonctionner Dalai avec une interface web, il faut d’abord construire le fichier Docker Compose :

docker-compose build Docker Compose téléchargera et installera Python 3.11, Node Version Manager (NVM) et Node.js.

À l’étape sept sur neuf, la construction semble se figer pendant que Docker Compose télécharge Dalai. Ne vous inquiétez pas : vérifiez l’utilisation de votre bande passante pour vous rassurer et simulez l’évolution d’organismes virtuels dans votre terminal pendant que vous attendez.

Vous finirez par revenir à l’invite de commande.

Dalai et les modèles LLaMa/Alpaca nécessitent beaucoup de mémoire pour fonctionner. Bien qu’il n’y ait pas de spécification officielle, une bonne indication est 4GB pour le modèle 7B, 8GB pour le modèle 13B, 16GB pour le modèle 30B, et 32GB pour le modèle 65B.

Les modèles Alpaca sont relativement petits, le modèle 13B atteignant un modeste 7,6 Go, mais les poids LLaMA peuvent être énormes : le téléchargement équivalent 13B atteint 60,21 Go, et le modèle 65B occupera un demi-terabyte épique sur votre disque dur.

Choisissez le modèle qui convient le mieux à vos ressources et utilisez la commande suivante pour l’installer :

docker-compose run dalai npx dalai alpaca install 13B Ou :

docker-compose run dalai npx dalai llama install 13B Il est possible que les modèles téléchargés via Dalai soient corrompus. Si c’est le cas, téléchargez-les plutôt à partir de Hugging Face.

Une fois que vous êtes revenu à l’invite de commande, lancez Docker Compose en mode détaché :

docker-compose up -d Vérifiez que le conteneur fonctionne correctement avec :

docker-compose ps Si tout fonctionne comme il se doit, ouvrez un navigateur web et entrez localhost:3000 dans la barre d’adresse.

Amusez-vous avec votre propre modèle de langue sous Linux

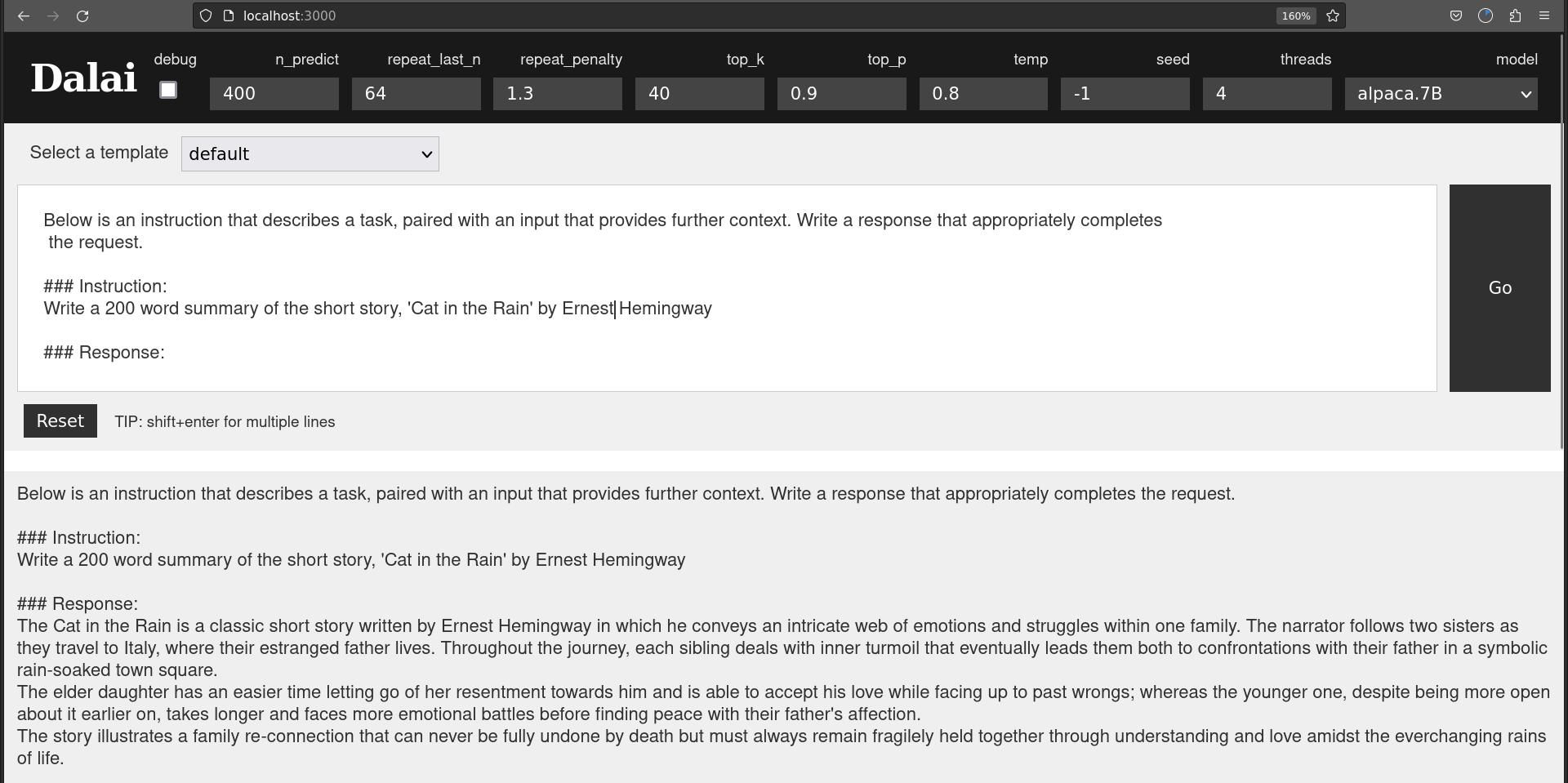

Lorsque l’interface web s’ouvre, vous voyez une zone de texte dans laquelle vous pouvez écrire vos messages.

Il est difficile d’écrire des messages efficaces, et les développeurs de Dalai ont fourni une série de modèles qui vous aideront à obtenir une réponse utile de la part de Dalai.

Ces modèles sont les suivants AI-Dialog, Chatbot, Défaut, Instruction, Réécriture, Traduire, et Tweet-sentiment.

Comme on peut s’y attendre, la AI-Dialog et Chatbot Les modèles de Chatbot sont structurés de manière à vous permettre de tenir une sorte de conversation avec le LLM. La principale différence entre les deux est que le chatbot est censé être « très intelligent », tandis que le AI-Dialog est « serviable, gentil, obéissant, honnête et connaît ses propres limites ».

Bien sûr, il s’agit de votre « IA », et si cela vous plaît, vous pouvez modifier l’invite pour que le chatbot soit muet, et que les caractéristiques du dialogue-IA soient « sadiques » et « inutiles ». C’est vous qui décidez.

Nous avons testé le Traduire La fonction « Translate » a consisté à copier le premier paragraphe d’un article de la BBC et à demander à Dalai de le traduire en espagnol. La traduction était bonne, et lorsque nous l’avons passée dans Google Translate pour la retranscrire en anglais, nous avons constaté qu’elle était tout à fait lisible et qu’elle reprenait les faits et le sentiment de l’article original.

De même, le Réécriture a transformé le texte de manière convaincante en ouverture d’un nouvel article.

Le Défaut et Instruction sont structurés pour vous aider à poser des questions ou à donner des instructions directes à Dalai.

La précision des réponses de Dalai varie considérablement en fonction du modèle utilisé. Un modèle 30B sera beaucoup plus utile qu’un modèle 7B. Mais même dans ce cas, on vous rappelle que les LLM ne sont que des systèmes sophistiqués permettant de deviner le mot suivant dans une phrase.

Ni le modèle 7B ni le modèle 13B Alpaca n’ont été en mesure de fournir un résumé précis de 200 mots de la nouvelle « Cat in the Rain » d’Ernest Hemingway, et tous deux ont inventé des intrigues et des détails tout à fait convaincants sur le contenu de l’histoire.

Et tandis que le dialogue IA « serviable, gentil, obéissant, honnête », qui « connaît ses propres limites », et le Chatbot « hautement intelligent » se rebiffent face à des demandes controversées, vous pouvez donner à Dalai une instruction directe ou une demande par défaut, et il écrira ce que vous voulez – comme vous le voulez.

Un grand modèle de langage sur votre machine Linux vous appartient

En exécutant un grand modèle linguistique sur votre propre machine Linux, vous n’êtes pas soumis à une surveillance ou à un retrait de service. Vous pouvez l’utiliser comme bon vous semble sans craindre les conséquences d’une violation de la politique de contenu de l’entreprise.

Si vos ressources informatiques sont limitées, vous pouvez même exécuter un LLM localement sur un humble Raspberry Pi.