ChatGPT a pris d’assaut le monde technologique, et les avancées et les mises à jour ne manquent pas. Mais malgré l’utilisation d’une technologie avancée, il y a quelques facteurs limitants dans la version actuelle.

L’un de ces facteurs est le système de jetons, qui continue de rompre le cycle d’évolution, mettant à mal l’utilité de l’application. Si vous utilisez ChatGPT, vous voudrez peut-être en savoir plus sur les jetons de ChatGPT et sur ce qu’il faut faire lorsque vous n’avez plus de jetons.

Prenons un peu de recul et donnons un aperçu de tout ce qu’il y a à savoir sur les mécanismes de fonctionnement sous-jacents de l’application.

Qu’est-ce qu’un jeton ChatGPT ?

Si vous vous fiez à la façade de l’application, tout ce que vous voyez est un langage informatique qui obéit à vos commandes et vous donne les réponses que vous cherchez. Cependant, le backend n’est rien d’autre que du code, qui apprend à chaque instant et se met au diapason des questions auxquelles il répond.

ChatGPT convertit chaque mot en un jeton lisible chaque fois que vous posez une question. Pour aller plus loin, les jetons sont des fragments de texte, et chaque langage de programmation utilise un ensemble différent de valeurs de jetons pour comprendre les exigences.

Comme les ordinateurs ne comprennent pas directement les valeurs textuelles, ils les décomposent en une combinaison de nombres, souvent appelée embeddings. Vous pouvez même considérer les intégrations comme des listes Python, qui ressemblent à une liste de nombres apparentés, tels que [1.1,2.1,3.1,4.1…n].

Une fois que ChatGPT a reçu l’entrée initiale, il tente de prédire la prochaine entrée possible sur la base des informations précédentes. Il sélectionne la liste complète des mots-clés précédents et, en utilisant sa synthèse de codage, tente d’anticiper l’entrée suivante de l’utilisateur. Il utilise et prédit un jeton à la fois afin de simplifier la compréhension de l’usage par le langage.

Pour améliorer les prédictions et la précision, il reprend toute la liste des enchâssements et la fait passer par des couches de transformation afin d’établir des associations entre les mots. Par exemple, lorsque vous posez une question telle que « Qui est Thomas Edison ? », ChatGPT retient les mots les plus utiles de la liste : Qui et Edison.

Les couches de transformation ont leur rôle à jouer dans l’ensemble du processus. Ces couches sont une forme d’architecture de réseau neuronal entraînée à sélectionner les mots-clés les plus pertinents à partir d’une chaîne de mots. Toutefois, le processus de formation n’est pas aussi simple qu’il y paraît, car il faut beaucoup de temps pour former des couches de transformateurs sur des gigaoctets de données.

Même si ChatGPT ne prédit qu’un seul mot à la fois, sa technologie auto-régressive est programmée pour prédire et alimenter le modèle principal afin de libérer la sortie. Le modèle est réglé pour ne s’exécuter qu’une seule fois pour chaque mot, de sorte que le résultat est imprimé un mot à la fois. La sortie s’arrête automatiquement lorsque l’application rencontre une commande d’arrêt du jeton.

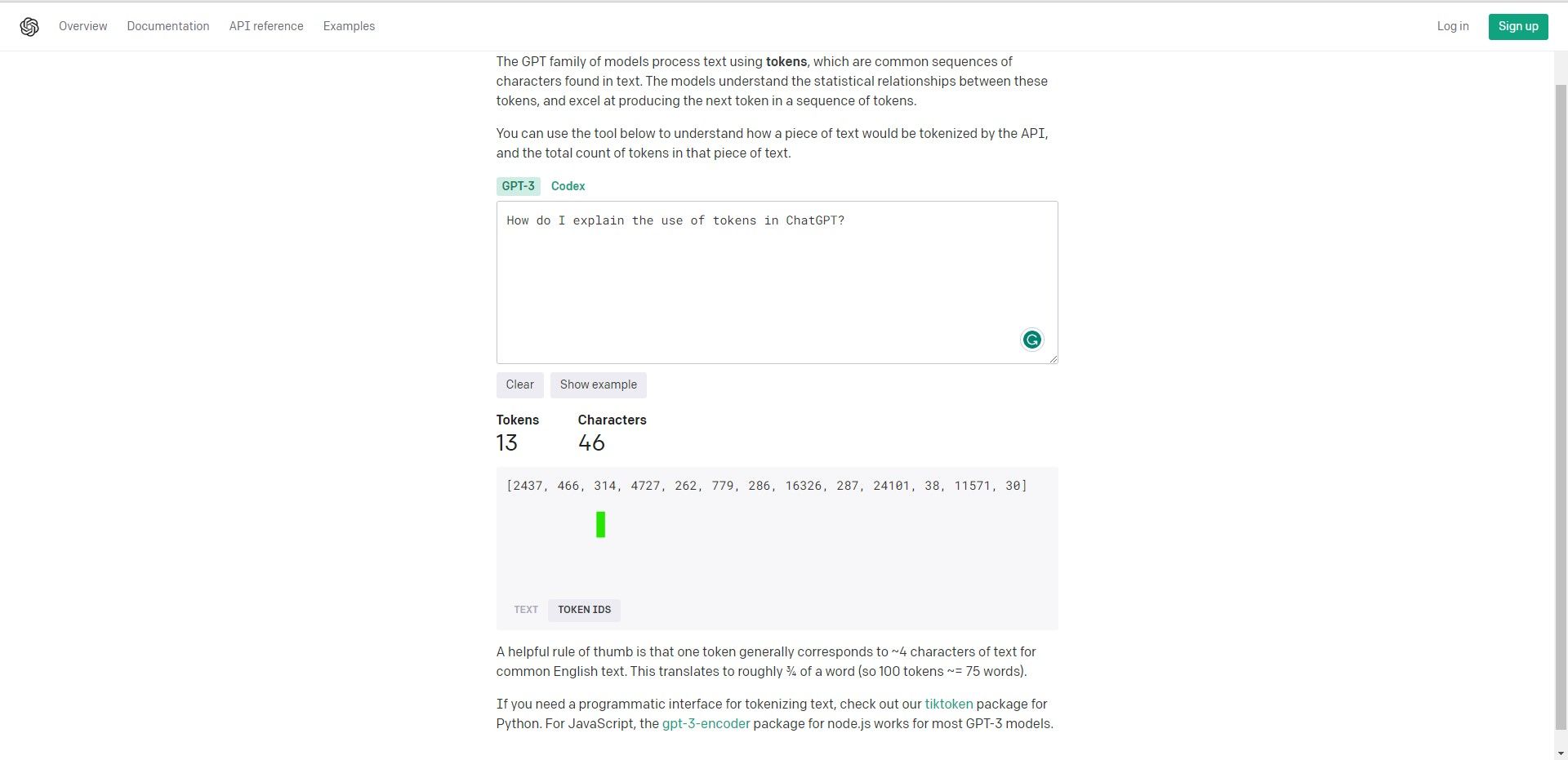

Par exemple, si vous regardez la calculatrice de jetons sur le site de ChatGPT, vous pouvez calculer votre utilisation de jetons en fonction de vos questions.

Entrons un exemple de texte, comme par exemple :

How do I explain the use of tokens in ChatGPT? D’après la calculatrice, cette chaîne comporte 46 caractères, ce qui consommera 13 jetons. Si l’on décompose ce texte en Token ID, cela donne à peu près ceci :

[2437, 466, 314, 4727, 262, 779, 286, 16326, 287, 24101, 38, 11571, 30] Selon le calculateur de jetons d’OpenAI :

Une règle empirique utile est qu’un token correspond généralement à ~4 caractères de texte pour un texte anglais courant. Cela correspond à environ ¾ d’un mot (donc 100 tokens ~= 75 mots).

Tokens gratuits et payants

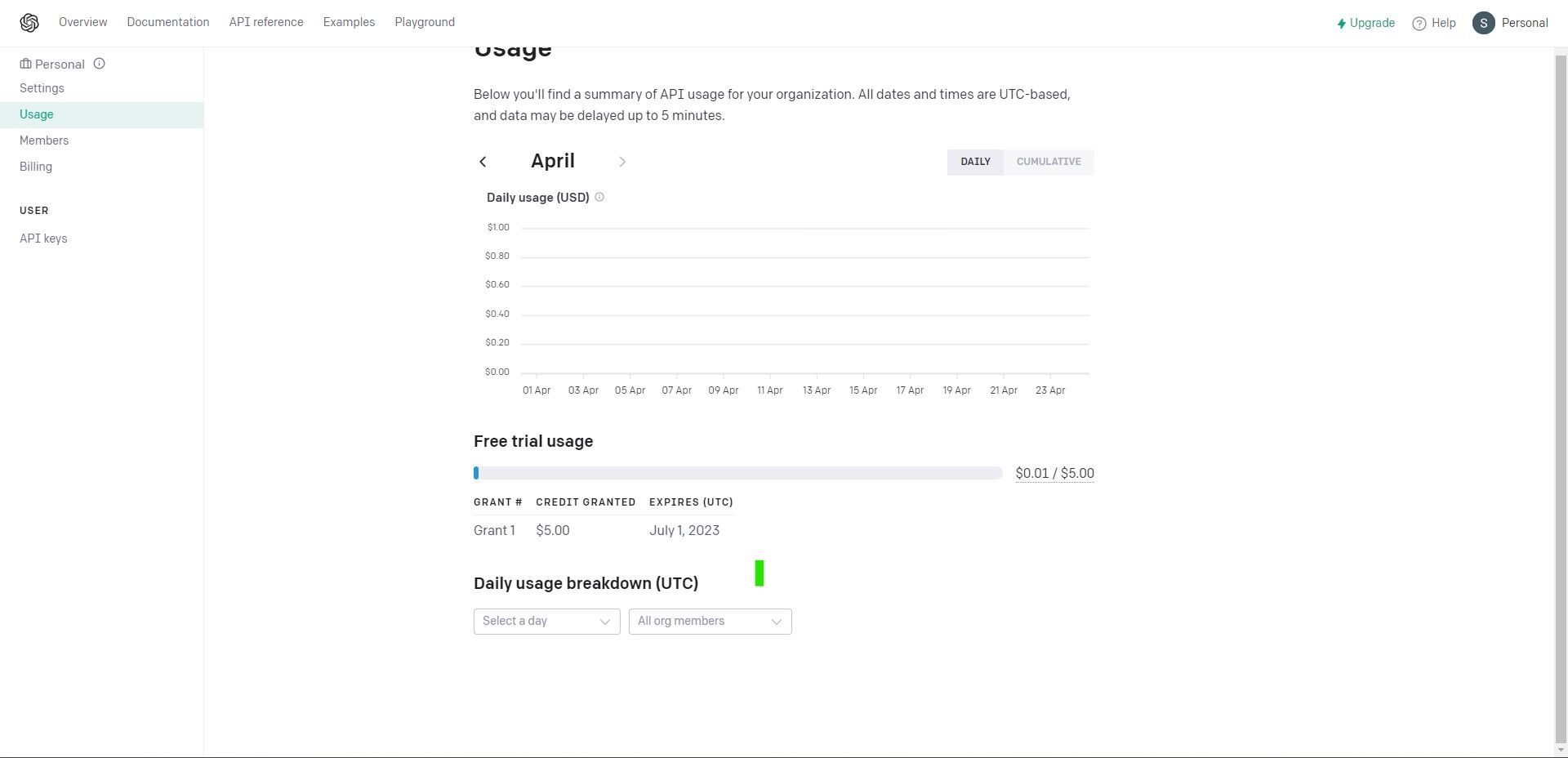

Pour vous donner une idée de ce qui se passe dans l’application ChatGPT, OpenAI vous offre un abonnement gratuit à un nombre limité de jetons. Si vous souhaitez expérimenter l’API ChatGPT, utilisez le crédit gratuit de 5 $, qui est valable pendant trois mois. Une fois la limite épuisée (ou la période d’essai terminée), vous pouvez payer au fur et à mesure, ce qui augmente le quota maximum à 120 $.

ChatGPT Plus : l’abonnement payant en vaut-il la peine ?

Pour aller plus loin, vous pouvez même vous inscrire à l’offre ChatGPT Plus, qui vous coûtera 20 $ par mois. Compte tenu de l’utilisation intensive et de la popularité de l’ensemble du modèle AI, voici les principales caractéristiques du modèle d’abonnement payant :

- Accès à ChatGPT, même lorsque le site Web connaît des temps d’arrêt en raison d’un afflux d’utilisateurs.

- Amélioration des taux de réponse

- Accès direct aux nouvelles fonctionnalités et versions

Si vous pensez que ces fonctionnalités en valent la peine et sont dans vos cordes, vous pouvez souscrire à l’abonnement payant et en bénéficier immédiatement.

Structure de prix du Token ChatGPT

Il existe différents modèles d’application, que vous pouvez choisir en fonction de vos besoins :

Modèle | Prix pour 1000 tokens (prompt) | Prix pour 1000 tokens (achèvement) |

|---|---|---|

Ada | $0.0004 | $0.0004 |

Babbage | $0.0005 | $0.0005 |

Curie | $0.0020 | $0.0020 |

DaVinci | $0.0200 | $0.0200 |

ChatGPT | $0.0020 | $0.0020 |

GPT-4 8k context | $0.0300 | $0.0600 |

Contexte GPT-4 32k | $0.0600 | $0.1200 |

Ada est le modèle le plus rapide, tandis que DaVinci est le modèle le plus puissant de cette liste de modèles. L’invite est la question, tandis que la complétion traite des réponses.

Limites maximales de jetons

Chaque modèle vous permet de définir le nombre maximum de jetons dans chaque requête. Cette méthode permet de contrôler le nombre maximal de jetons que l’application génère en un seul appel, limitant ainsi le résultat. La fonctionnalité max_token est très utile, en particulier lorsque vous souhaitez contrôler la longueur de votre résultat tout en évitant d’abuser de votre utilisation de jetons et de vos crédits. La longueur par défaut est fixée à 2048 jetons, tandis que le maximum peut être fixé à 4096 jetons.

Restreindre l’utilisation des jetons peut entraîner des réponses courtes, ce qui risque de limiter les résultats et de nuire à votre expérience d’utilisation.

ChatGPT3 a une limite supérieure de 4096 ; cependant, avec l’introduction de ChatGPT4, les limites de jetons sont augmentées, comme suit :

Modèle | Prix pour 1000 tokens (prompt) |

|---|---|

Ada | 2048 |

Babbage | 2048 |

Curie | 2048 |

DaVinci | 4096 |

ChatGPT | 4096 |

Contexte GPT-4 8k | 8192 |

Contexte GPT-4 32k | 32768 |

Si votre résultat est tronqué, vous devez augmenter la limite maximale spécifiée dans votre tableau de bord. N’oubliez pas que la somme de vos jetons prompts et maximums doit toujours être inférieure ou égale à la limite maximale de jetons du modèle.

Par exemple, dans le modèle ChatGPT, le jeton prompt_tokens + max_tokens <= 4096 jetons.

Apprenez à contrôler vos invites ChatGPT pour de meilleurs résultats

Quelle que soit la manière dont vous utilisez l’application pilotée par l’IA, il est probable que vous devrez trouver des moyens de jouer intelligemment avec vos questions et vos phrases. En fonction de vos habitudes d’utilisation, vous utiliserez probablement ChatGPT de manière intensive pour chaque tâche.

Pour obtenir les meilleurs résultats, vous devez apprendre à travailler avec la méthodologie des jetons et améliorer vos compétences pour vous assurer que vos limites d’utilisation restent intactes tout en vous donnant les meilleures réponses possibles.